Smart Navigation

Wie ist es möglich einen simplen Roboterarm aufzuwerten – sodass er ein autonom agierender Detektiv wird?

Die Antwort auf diese Frage liefert unser Smart Navigation Showcase!

Ziele des Showcases

Innovationen aus den Bereich autonomer Navigation und Anwendungsfälle für künstliche Intelligenz funktionieren nur auf modernsten Robotern und nicht auf älteren Geräten? – Von wegen!

Unser Showcase Smart Navigation zeigt wie es möglich ist auch komplexe Anwendungsfälle wie das Erkennen und Verfolgen eines beliebigen Gegenstandes auf einem kleinen, simplen Roboterarm zu realisieren – auch wenn man initial nicht mehr als eine serielle Schnittstelle zur Verfügung hat!

Darüber hinaus zeigt er exemplarisch wie mit den daraus resultierenden Live-Maschinendaten des Roboters intelligent verfahren werden kann und wie diese sowohl angereichert wie auch statistisch ausgewertet werden können.

Folgendes Video geht im Detail darauf ein:

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von YouTube.

Mehr erfahren

Der Aufbau

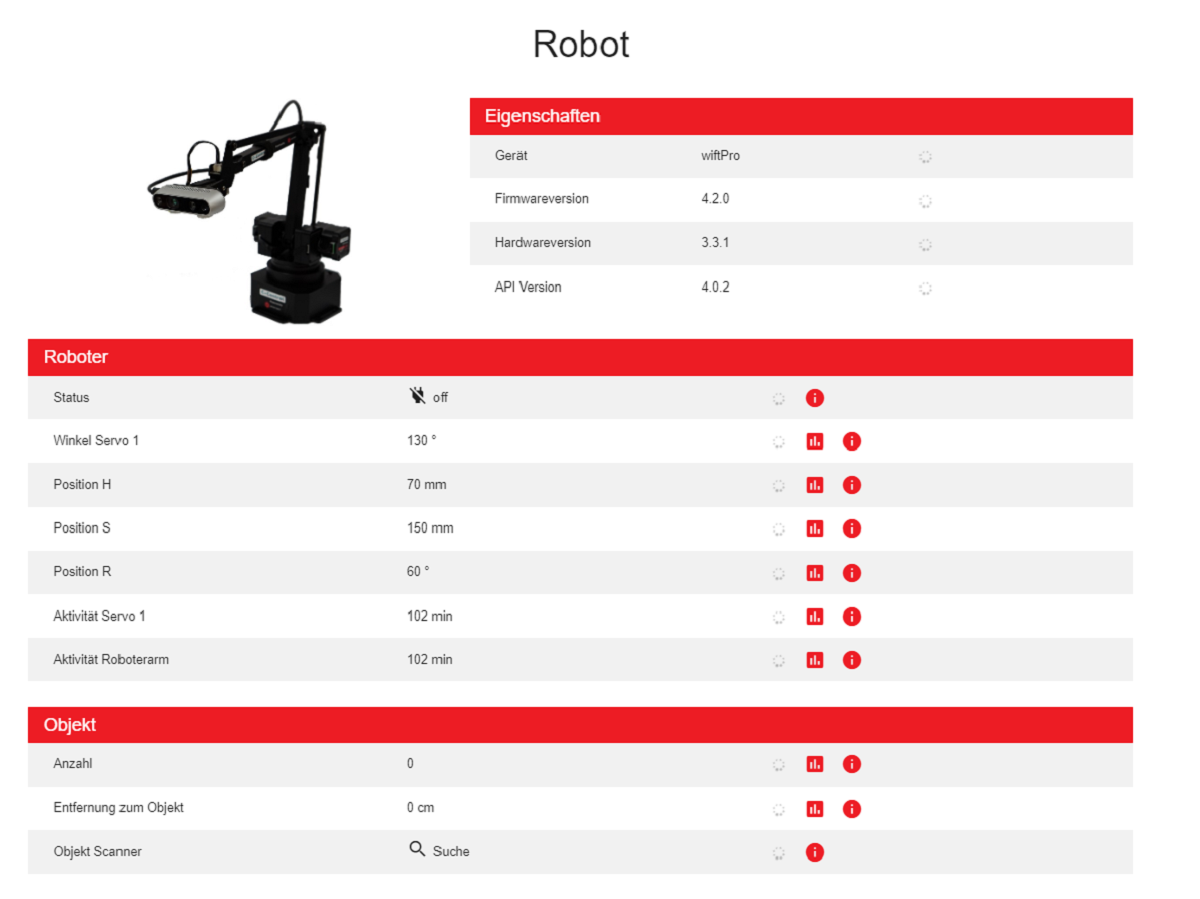

Simpler Roboterarm der Firma UFACTORY (uarm). Aufgewertet mit einer INTEL Realsense Stereo-Tiefenkamera.

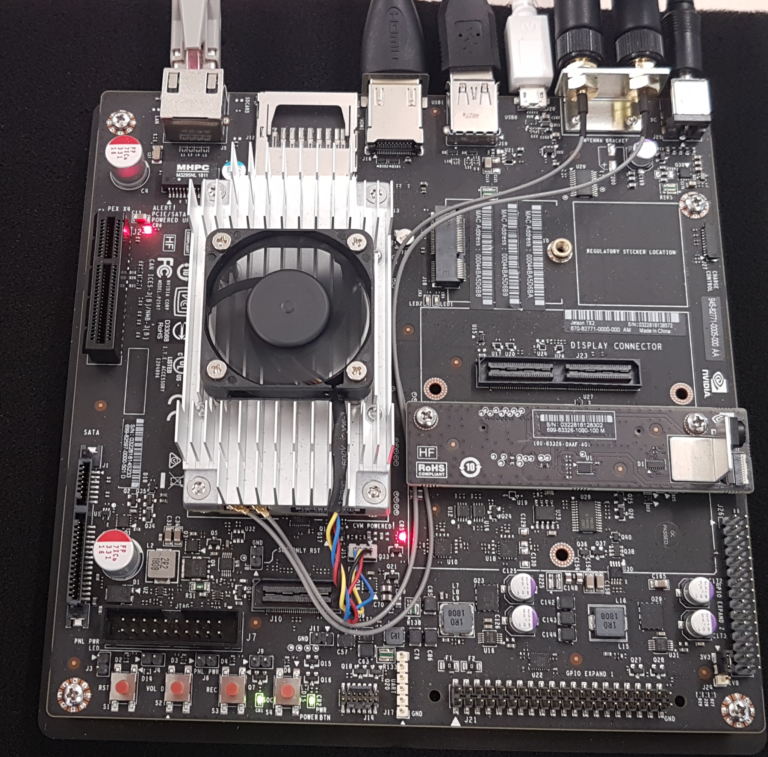

Ein NVIDIA Jetson TX-2 – Das Herzstück des Setups.

Hier werden das neuronale Netz ausgeführt und die Robotersteuerung koordiniert.

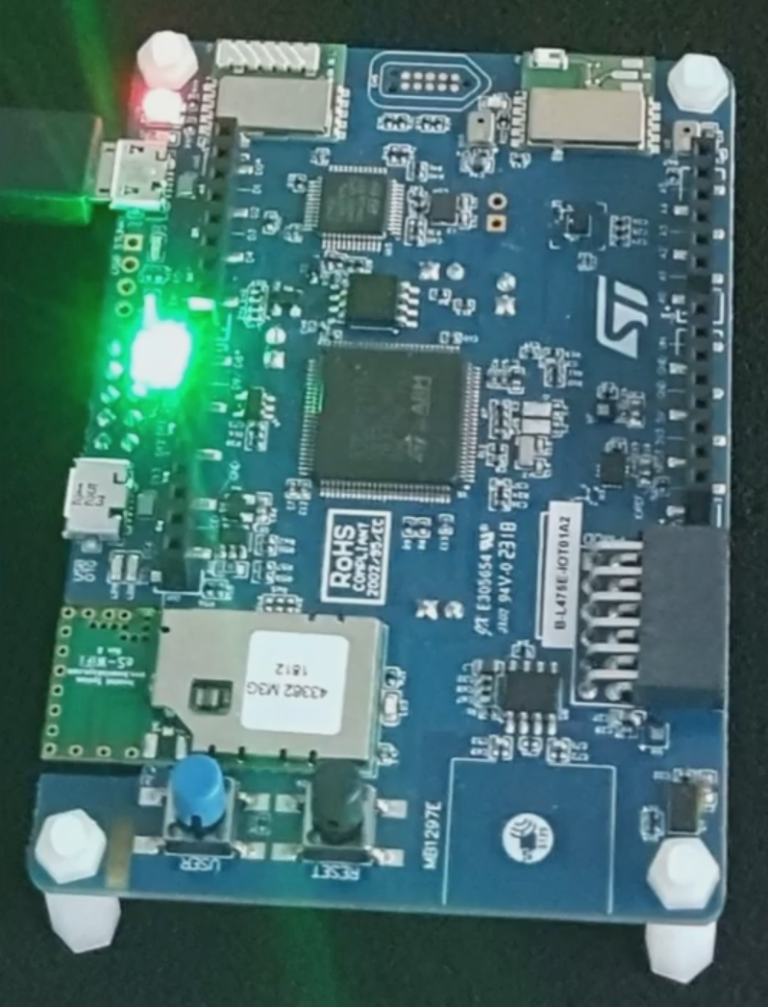

Eine IOT-Sensornode erweitert das Sensorwert-Spektrum des Roboters. Er ist nun auch in der Lage weitere physikalische Größen wie Temperatur, Luftdruck und Erschütterung zu messen, statistisch auszuwerten und darauf zu reagieren.

Technologie & Software

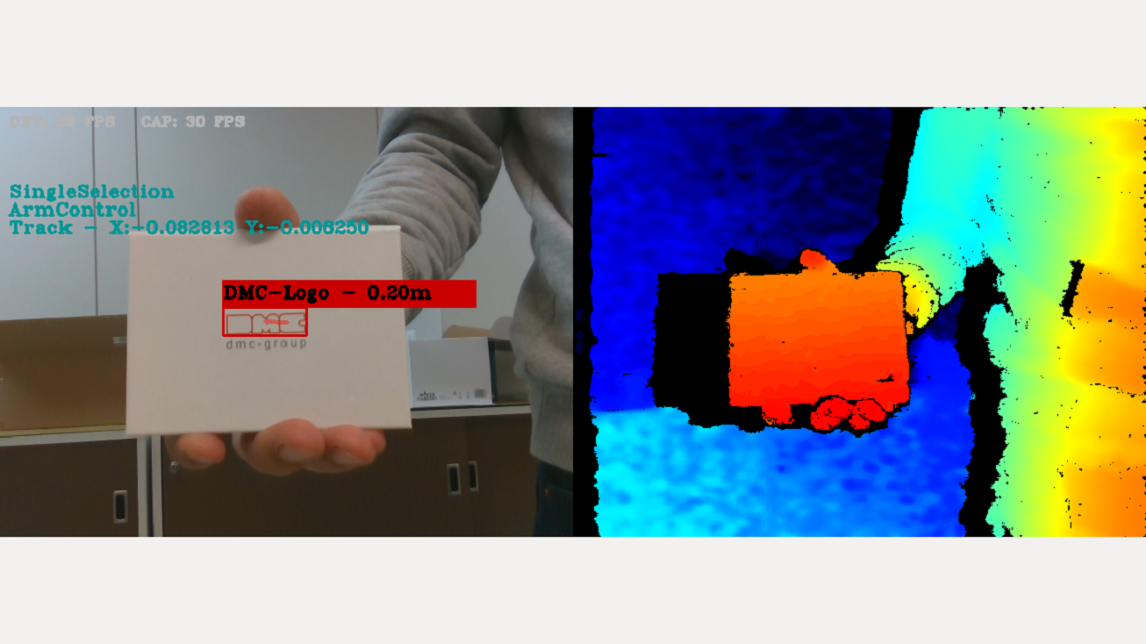

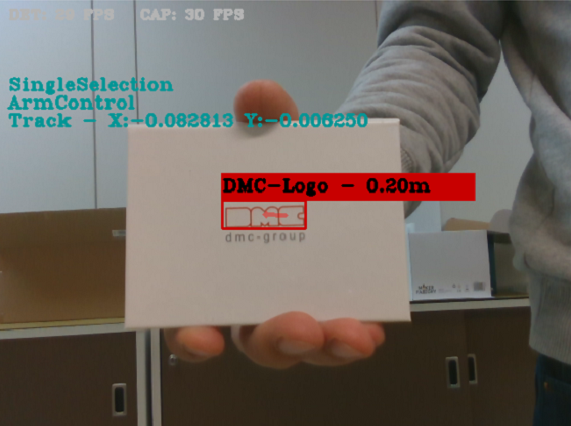

Die INTEL Realsense Stereo Kamera liefert zwei verschiedene Arten von Videos.

Auf der einen Seite eine RGB-basiertes Video mit einer Auflösung von 640×480.

Der zweite Videostream basiert auf einem Infrarot-Tiefenbild. Hier besitzt jeder Pixel einen definierten Abstandswert der durch eine Farbcodierung dargestellt wird. Ein roter Pixel steht für einen kleinen Abstand zur Kamera, blau für einen größeren Abstand zur Kamera.

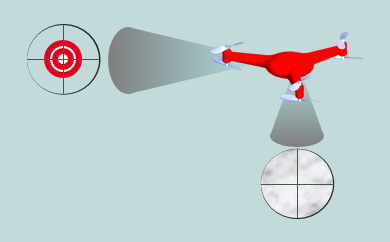

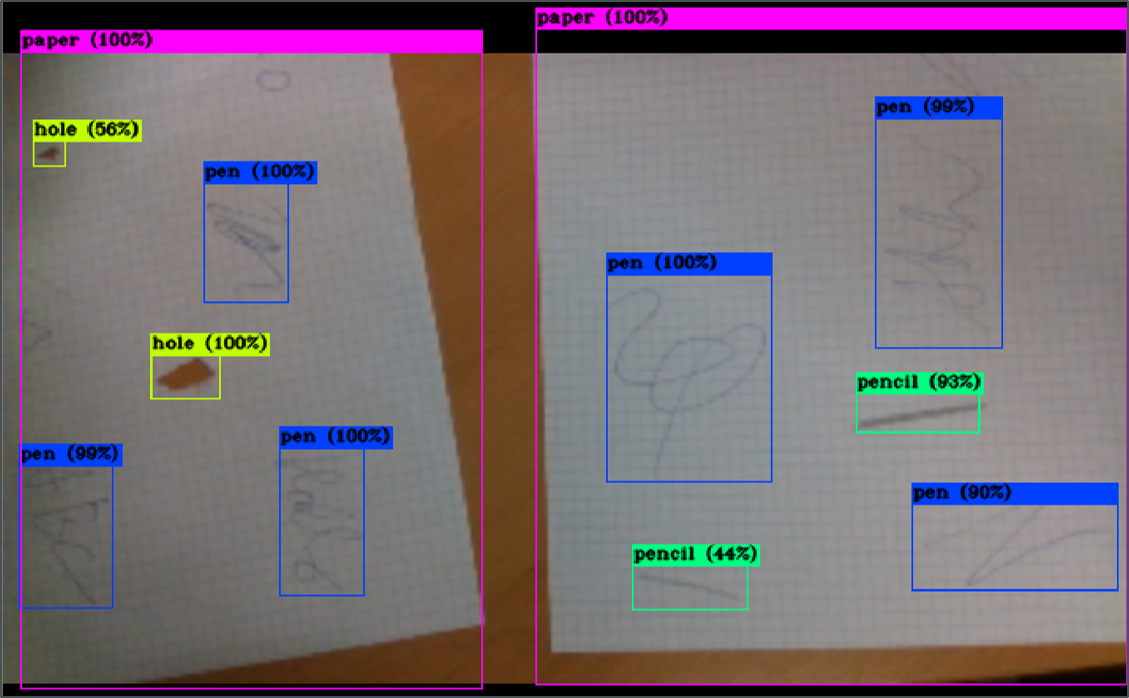

Die Basis des Smart Navigation Showcases bildet die Objekterkennung mit tinyYOLO und der programmierten Echtzeit-Koordination des Roboterarms. Um zu zeigen, dass bei der Objekterkennung (fast) keine Grenzen gesetzt sind, haben wir uns für das Training mit unserem dmc-group Logo entschieden.

Nach knapp 300 Bildern im Trainingsdatensatz und einigen Stunden Rechenzeit auf unseren Hochleistungsrechnern in Paderborn war das neuronale Netz ausreichend zur zuverlässigen Erkennung unseres Logos trainiert. Obwohl das Training selbst viele Ressourcen benötigte, lässt sich das neuronale Netz selbst auf kleineren embedded Geräten betreiben – es ist also kein high-end Server notwendig.

Der Betrieb des Roboterarms selbst basiert auf einer Bild-für-Bild Erkennung des Objekts (Kamera liefert stabile 30 fps). Durch Berechnung der Differenz der Positionen des trainierten Objekts im Videostream wird ein Bewegungsvektor (Roter Pfeil) berechnet und für die Maschinensteuerung übersetzt. Nun ist es dem Roboterarm möglich dem trainierten Objekt in Echtzeit (innerhalb seiner Freiheitsgrade) zu folgen.

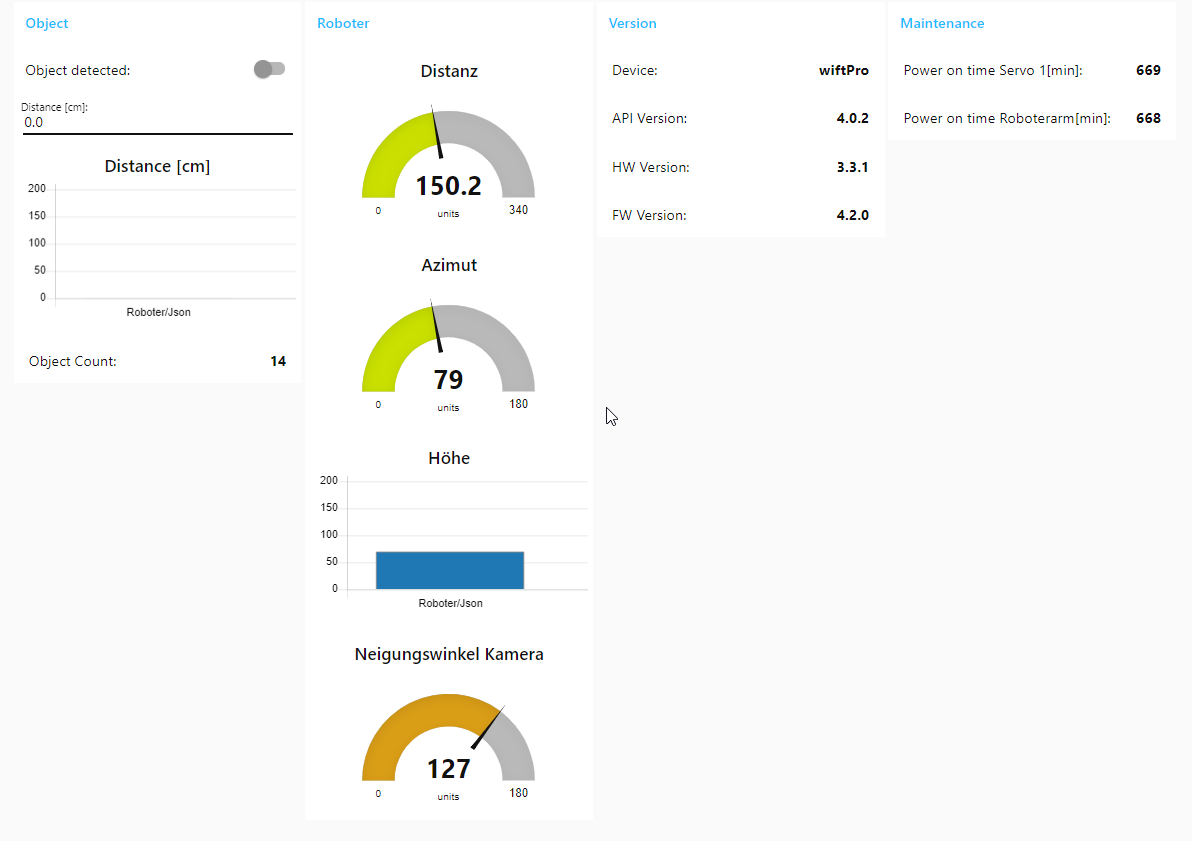

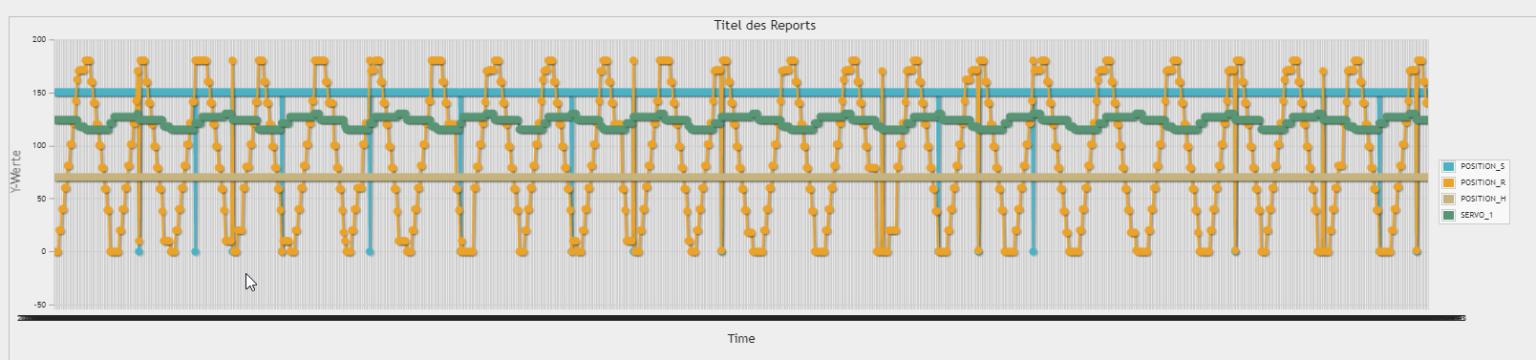

Das auf Node-RED basierende Dashboard zeigt die Live-Daten des Roboterarms an. Echtzeiterfassung der Maschinenwerte, wie zum Beispiel die Anzahl der erkannten Objekte, der Azimutwinkel des Arms oder die Distanz zum Objekt, können hier eingesehen werden.

Da das Dashboard frei konfigurierbar in der Darstellung ist, lassen sich hier nach Belieben nicht benötigte Werte ausblenden oder zusätzliche Werte abbilden (bspw. Input aus den Messwerten des IOT-Sensornode).

Der Roboterarm selbst benötigt keine aktive Cloud-Verbindung um seine Tätigkeit auszuführen.

Falls benötigt lassen sich die Informationen des Roboters über das Web zugänglich machen indem die Dashboard-Daten in eine Cloud exportieren werden. Dies kann zur Fernüberwachung oder zum Anzeigen der Maschinenwerte auf mobilen Endgeräten genutzt werden.

Analyse & Daten

Diese gesammelten Daten lassen sich nun nicht nur anzeigen, sondern auch statistisch aufbereiten und auswerten.

Als erstes Beispiel lässt sich, wie hier gezeigt, die Position des erkannten Objekts über die Zeit graphisch darstellen. So ist es möglich die Trajektorie des Objekts im 3-Dimensionalem Raum darzustellen.

Sobald man genügend Daten gesammelt wurden, können diese im zeitlichen Verlauf dargestellt und auswertet werden.

Dies ist nützlich um Korrelationen zwischen verschiedenen Datenströmen bei der Fehleranalyse aufzudecken.

Beispielsweise bei einer Fehlfunktion im Servermotor des Roboterarms nachdem jemand an den Roboter gestoßen ist (=der Erschütterungssensor des IOT Nodes ausgelöst wurde). Oder bei einer Verschlechterung der Roboterleistung, nachdem er heiß gelaufen ist (=der Temperatursensor bereits seit einem längeren Zeitraum eine erhöhte Temperatur des Roboters erkannte)

Selbstverständlich lassen sich diese Informationen nicht nur zur Fehleranalyse, sondern auch zur Fehlerprävention einsetzen. Dies kann in Form von einfachen, programmierten Reaktionen sein – beispielsweise dem Verringern der Bewegungsgeschwindigkeit solange der Temperatursensor eine erhöhte Temperatur anzeigt.

Etwas komplexer, aber umso vielversprechender, kann auch ein Ansatz zur Vorhersage von Fehlerzuständen sein (Stichwort predictive maintenance). Hierbei würden die Maschinendaten selbst durch ein trainiertes neuronales Netz überwacht werden. Das Grundprinzip ist es ein spezifisches Fehlermuster einer Maschine zu erkennen und frühzeitig Warnungen vor einer bevorstehenden Beeinträchtigung des Betriebs zu senden, sodass darauf rechtzeitig reagiert werden kann.

Weitere Anwendungsfälle

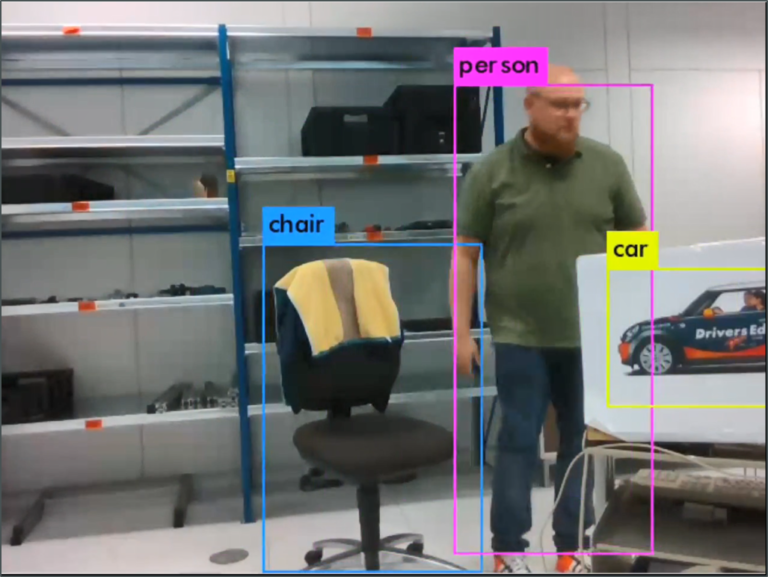

Wie anfangs angesprochen ist diese Technologie sehr vielseitig. Das trainierte Objekt / die trainierten Objekte müssen also keine Schriftzeichen sein.

Hier auf der rechten Seite finden Sie einige Beispiele für das Erkennen von Menschen und anderen Objekten, wie Stühlen oder Fahrzeugen.

Für die Erkennung eines unbekannten neuen Objekts muss das neuronale Netz erneut trainiert werden – wie in unserem Fall zur Erkennung unseres Logos. Dazu wird zunächst ein ausreichend großer und qualitativ hochwertiger Testdatensatz an Bildmaterial benötigt.

Sobald das Training erfolgreich abgeschlossen wurde, lassen sich aber nahezu alle beliebigen Objekte zuverlässig erkennen – die Bandweite reicht von Gesichtserkennung bis hin zur Identifikation von (Teil-)Produkten in einer Fabrik während des Produktionsprozesses.

Für einen Anwendungsfall im Kontext Qualitätssicherung ist sicherlich auch die Möglichkeit der Erkennung von Produktionsfehlern in einem Produkt interessant.

Ein weiteres denkbares Szenario wäre die Klärung aus der Luft bei einer unübersichtlichen Situation mithilfe von Thermalbildern.

Beispielsweise wenn bei einem Waldbrand Personen vermisst werden und Rettungskräfte trotz Rauchentwicklung beurteilen müssen, ob sie in ein Gebiet vordringen sollen oder nicht.

Oder wenn ein System benötigt wird, das Menschen aktiv vor Gefahren warnt – beispielsweise beim Betreten einer bestimmten Gefahrenzone, wie Be- und Entladezonen autonomer Lagerroboter im Bereich der automatisierten Logistik

Natürlich lassen sich diese Beispiele beliebig erweitern…

Gemeinsam auf zu neuen Horizonten

Smart Navigation ist genau das nachdem Sie gesucht haben?

Oder haben Sie womöglich gleich die nächste Aufgabe im Gepäck?

So oder so – wir helfen Ihnen herauszufinden ob und wie sie diese KI-Anwendung für sich nutzen können!

Unser Team steht für Sie bereit

Eine kurze Mail an sales@dmc-smartsystems.dmc-group.com oder ein Anruf (+49 89 427 74 177) genügt.